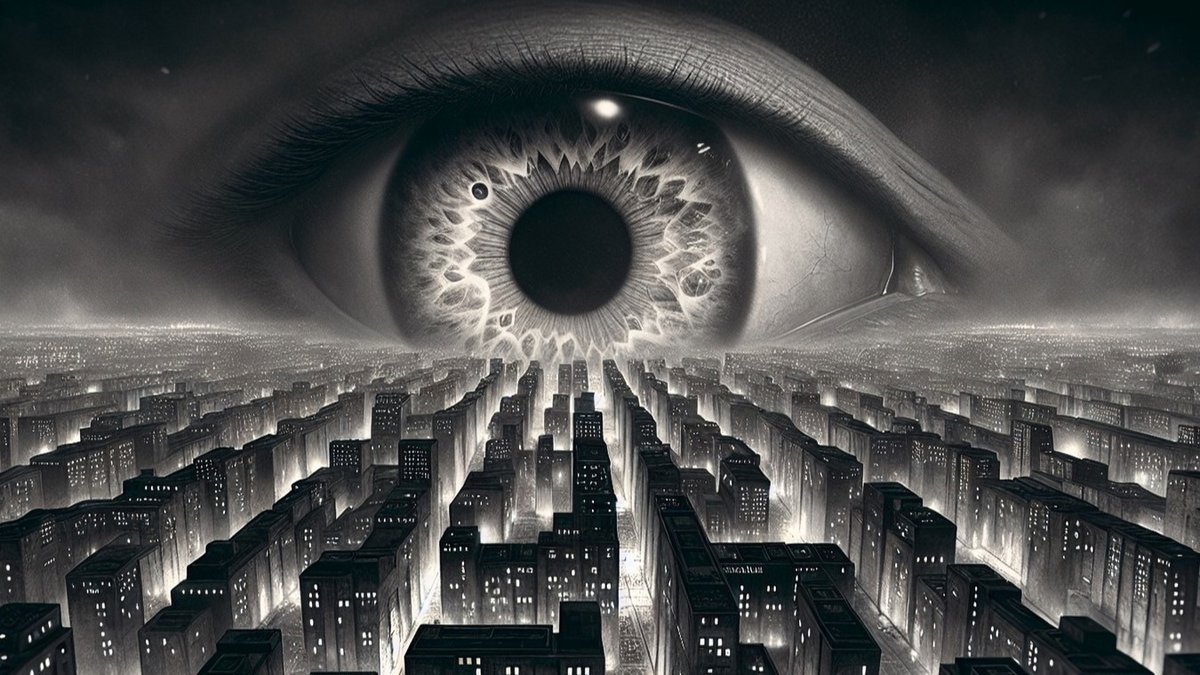

Overheden gebruiken steeds vaker AI. Maar wat als de algoritmes zelf vooroordelen overnemen en mensenrechten onder druk komen te staan?

Dankzij enorme investeringen in Europa neemt het gebruik van AI-systemen in de publieke sector rap toe. Ook in België bestaat sinds enkele jaren strategisch beleid om AI-gebruik door overheidsinstanties te stimuleren. Het gaat dan niet enkel om generatieve AI-toepassingen, zoals chatbots voor burgers met vragen of CoPilot-licenties voor Vlaamse ambtenaren, maar ook over fraudedetectie in belastingsystemen en uitbetalingsystemen voor sociale uitkeringen, screening van werkzoekenden, gezichtsherkenningscamera's voor de politie, en andere "efficiëntieslagen" om grote hoeveelheden gegevens van burgers te analyseren en voorspellingen te doen.

Naast efficiëntie en kostenbesparing wordt vaak als reden voor het overschakelen op AI-toepassingen aangevoerd dat het menselijke vooroordelen kan uitschakelen. AI zou neutraal en objectief tot resultaten komen. Maar dat is een illusie: historische data worden gebruikt om een AI-model te trainen, en daarmee worden de vooroordelen uit het verleden erin gebakken.

Een voorbeeld is dat bij het screenen van sollicitanten voor een managementfunctie een AI-model dat getraind is op data van managers van de afgelopen 50 jaar, de voorkeur zal geven aan mannelijke kandidaten. Over die periode waren de meeste managers mannen, omdat vrouwen lang werden geacht niet buitenshuis te werken, of te stoppen als er kinderen kwamen. Zelfs als een AI-model het geslacht van kandidaten niet kent, kan dat via andere kenmerken meespelen, zoals een dienstperiode in het leger of het type sport waarin kandidaten uitblinken. Een AI-model kan dan bij gedragspatronen die meer bij vrouwen voorkomen, concluderen dat die niet overeenkomen met het ideale profiel.

Een AI-toepassing kan concluderen dat het samenwonen van drie generaties in één woning "atypisch" is en noopt tot controle op gezinsuitkeringsfraude.

Zo erven AI-modellen menselijke vooroordelen. Een AI-toepassing kan concluderen dat het samenwonen van drie generaties in één woning "atypisch" is en noopt tot controle op gezinsuitkeringsfraude, zoals in Denemarken systematisch gebeurde. Of dat het hebben van een dubbele nationaliteit een risicofactor vormt voor kinderopvangtoeslagfraude, omdat dat voorheen tot extra controles leidde, zoals gebeurde bij de Toeslagenaffaire in Nederland. AI-modellen komen niet uit het niets, ze worden getraind op bestaande data en gestuurd door mensen. Ook AI is mensenwerk.

AI-toepassingen kunnen verder fouten oplopen door het ingeven van onjuiste parameters, of doordat de patroonherkenning toch niet perfect functioneert. Daarom worden foutenmarges aangegeven, bijvoorbeeld dat een model voor 95% een correcte voorspelling maakt. Wie met een AI-toepassing werkt, moet daarmee rekening houden. Geen enkel beleid heeft immers de intentie dat AI menselijke besluitvorming volledig overneemt; er wordt altijd netjes aangegeven dat AI-toepassingen ondersteunend zijn.

Maar ambtenaren die tegen het advies van een AI-toepassing ingaan, zullen dat moeten verantwoorden, terwijl bij een fout advies waar ambtenaren in meegaan, de schuld bij het AI-systeem kan worden gelegd. Bovendien gaat het om veelal ondoorgrondelijke technologie; veel mensen die ermee werken, kunnen niet zelf controleren of adviezen correct tot stand zijn gekomen. "Computer says no" is daarom ook bij AI een populair argument om niet door te vragen.

Ongelijke behandeling door een bevooroordeelde ambtenaar is ernstig, maar die ambtenaar heeft beperkte invloed, en kan bijgestuurd of ontslagen worden. Ongelijke behandeling op advies van een AI-systeem heeft echter grootschalige en langdurige effecten, want zo'n systeem wordt breed toegepast en is niet eenvoudig vervangen.

Voor een individu is het heel moeilijk aan te kaarten dat er vooroordelen meespelen bij bestuurlijke beslissingen. Ook slachtoffers hebben de neiging AI-systemen als objectief te zien. Wanneer ze niettemin ervan overtuigd zijn onrechtvaardig behandeld te worden, weten ze vaak niet hoe dat komt.

Gelijke behandeling is een mensenrecht. Andere mensenrechten komen ook in het gedrang, zoals het recht op een eerlijk proces, het recht op een privéleven en, vooral bij surveillancesystemen, de vrijheid van vergadering en vereniging, en de vrijheid van meningsuiting. Eenieder moet zich op de (in verdragen vastgelegde) mensenrechten kunnen beroepen tegenover de overheid. Maar hoe bewijs je als individu dat een intelligent en efficiënt overheidssysteem je rechten schendt?

Hoe bewijs je als individu dat een intelligent en efficiënt overheidssysteem je rechten schendt?

Transparantie wordt vaak aangewezen als de oplossing. Zo wees onlangs een Nederlandse rechter de minister van Buitenlandse Zaken terecht, omdat de immigratiedienst een AI-toepassing gebruikte waarvoor de impact op mensenrechten schijnbaar niet geëvalueerd was. Dat kon die rechter nagaan omdat Nederland een verplicht algoritmeregister heeft voor de overheid, wat voor Belgische overheden nog niet bestaat. Dat maakt het lastig voor rechters en toezichthouders om te beoordelen of burgers onrechtvaardig behandeld zijn. De stilte rondom AI‑gebruik bij Belgische overheden betekent geen afwezigheid van schandalen, maar verraadt een systemisch gebrek aan transparantie.

De vraag is echter of een individu veel kan met transparantie. Moeten we dan allemaal AI-experten worden om zelf overheidsalgoritmes te evalueren? Is het fair om het aankaarten van fouten op de schouders te leggen van burgers die zich juist tot de overheid richten voor steun - bij het betalen van kinderopvang of ziekenzorg, het vinden van werk, het beginnen van een bedrijf?

Voorkomen is beter dan genezen, zo geeft ook de AI Act aan. Hoe moet dat eruitzien in de praktijk? Ambtenaren kunnen evenmin allemaal AI-experten worden, hoewel basiskennis verondersteld mag worden voor wie met AI werkt. Veeleer moeten al die AI-trainingen die ambtenaren nu krijgen een grote component mensenrechtenkennis bevatten, evenals de opleiding van AI-ontwikkelaars. AI-systemen zijn feitelijk "socio-technische assemblages". Dat wil zeggen dat ze niet enkel bestaan uit technologie, maar ook uit de mensen die ermee werken, het beleid eromheen, werkroutines, enzovoort. Die hele assemblage moet mensenrechten respecteren. Voor daadwerkelijke bescherming van mensenrechten in tijden van AI, is daarom aan de kant van de overheid diepgaande kennis van de eigen verantwoordelijkheden op het vlak van mensenrechten een absolute noodzaak.